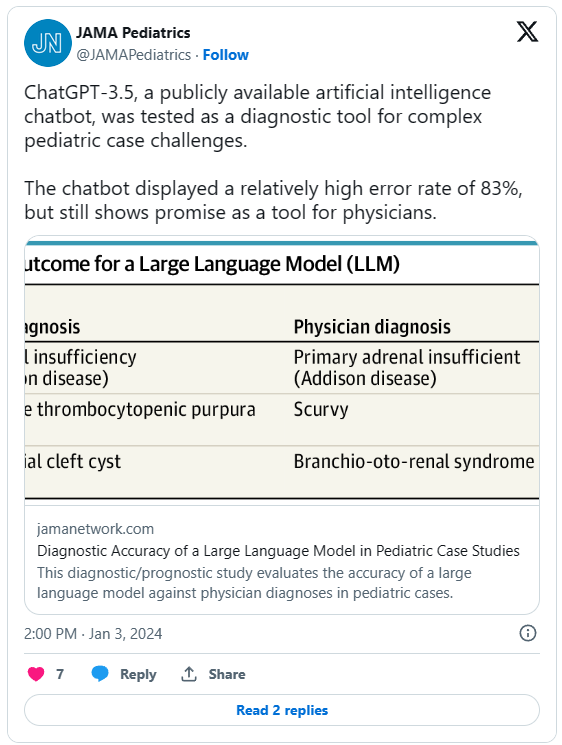

O ChatGPT da OpenAI não está tão perto de substituir médicos pediatras, já que o chatbot (cada vez mais avançado) não conseguiu diagnosticar com precisão a grande maioria dos casos pediátricos hipotéticos.

Através de um novo estudo publicado no JAMA Pediatrics em 2 de janeiro, conduzido por pesquisadores do Cohen Children’s Medical Center, em Nova York, os pesquisadores analisaram as respostas do bot a pedidos de diagnóstico médico de doenças infantis e descobriram que ele tinha uma taxa de erro de 83% em todos os testes.

O estudo usou o que são conhecidos como desafios de casos pediátricos, ou casos médicos originalmente postados para grupos de médicos como oportunidades de aprendizado (ou desafios diagnósticos) envolvendo informações incomuns ou limitadas. Os pesquisadores usaram 100 desafios publicados no JAMA Pediatrics e no New England Journal of Medicine (NEJM) entre os anos de 2013 e 2023.

O ChatGPT forneceu diagnósticos incorretos para 72 dos 100 casos experimentais fornecidos, e gerou 11 respostas que foram consideradas “clinicamente relacionadas” com o diagnóstico correto, mas consideradas muito amplas para serem corretas.

Os pesquisadores atribuem parte dessa falha à incapacidade da IA generativa de reconhecer relações entre certas condições e circunstâncias externas ou preexistentes, frequentemente usadas para ajudar a diagnosticar pacientes em um ambiente clínico. Por exemplo, o ChatGPT não conectou “condições neuropsiquiátricas” (como autismo) a casos comumente vistos de deficiência de vitaminas e outras condições baseadas em dieta restritiva.

O estudo conclui que o ChatGPT precisa de treinamento contínuo e envolvimento de profissionais médicos que alimentem a IA não com uma massa de informações gerada pela internet, que muitas vezes pode circular em desinformação, mas com literatura e experiência médica examinada.

Chatbots baseados em IA baseados em Large Language Models (LLMs) foram previamente estudados por sua eficácia no diagnóstico de casos médicos e na realização das tarefas diárias dos médicos. Em 2023, pesquisadores testaram a capacidade da IA generativa de passar no exame de licenciamento médico dos Estados Unidos e ela foi aprovada.

Mas, embora ainda seja altamente criticado por seus limites de treinamento, muitos grupos médicos, incluindo a Associação Médica Americana, não veem o avanço da IA no campo apenas como uma ameaça de substituição. Em vez disso, IAs mais bem treinadas são consideradas maduras por seu potencial administrativo e comunicativo, como gerar texto do lado do paciente, explicar diagnósticos em termos comuns ou gerar instruções. Usos clínicos, como diagnósticos, permanecem um tópico controverso e difícil de pesquisar.

Nessa medida, o novo relatório representa a primeira análise do potencial de diagnóstico de um chatbot em um ambiente puramente pediátrico, reconhecendo a formação médica especializada realizada por profissionais médicos. Suas limitações atuais mostram que mesmo o chatbot público mais avançado do mercado ainda não pode competir com toda a gama de conhecimentos humanos.

O estudo completo do JAMA pode ser acessado neste link.

+ There are no comments

Add yours